…puis aux autres directives et règlementations, tout en facilitant l’acculturation à l’IA dans l’entreprise.

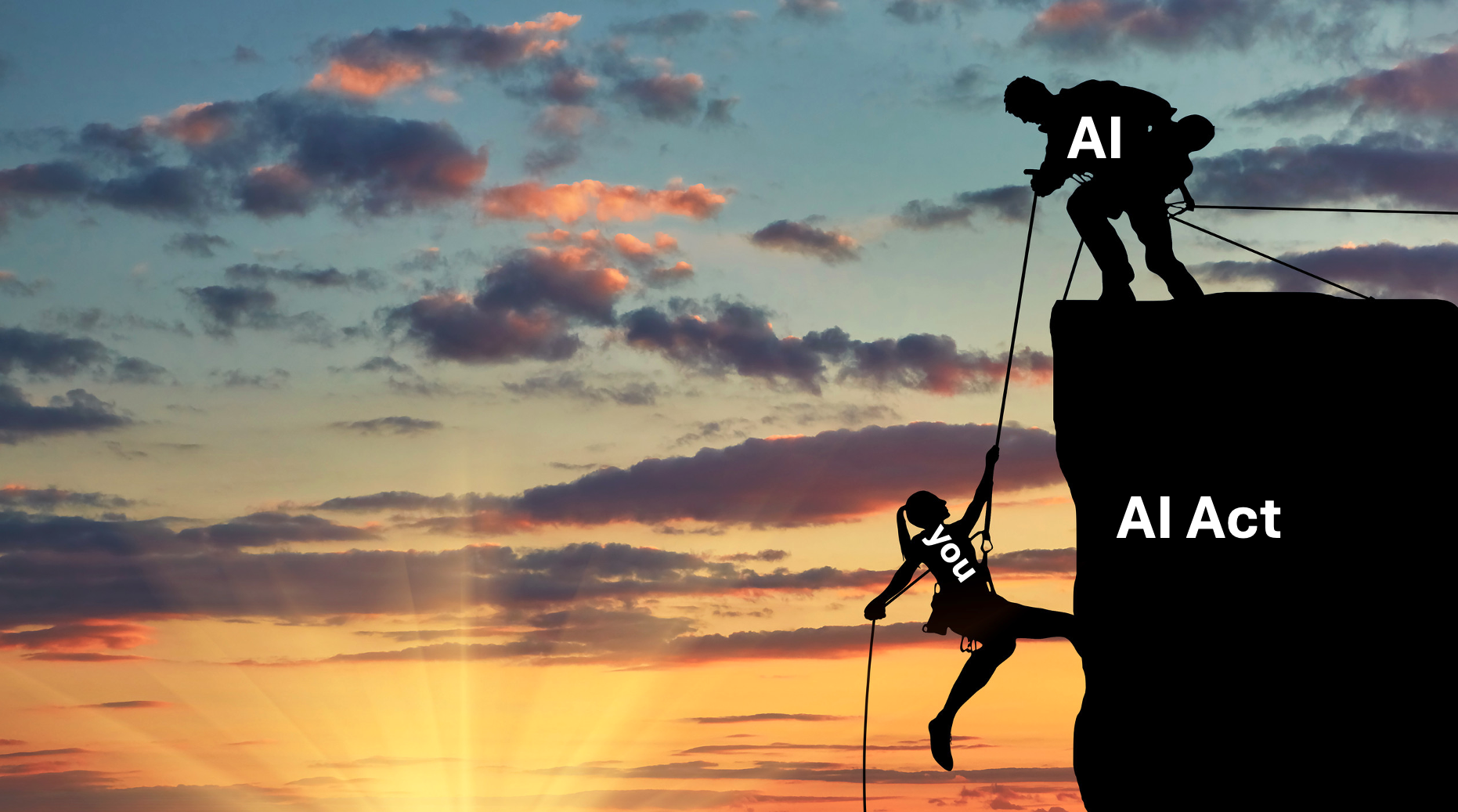

L'AI Act européen est entré en vigueur en 2024, mais c’est maintenant qu’il arrive comme un tsunami règlementaire sur les entreprises.

Pour le secteur bancaire en particulier, l'AI Act n'est pas un sujet anodin. L’utilisation de technologies IA pour la notation de crédit, la détection de fraude, le KYC ou l’évaluation des risques tombera dans la catégorie "haut risque".

Cela implique des exigences strictes en matière de transparence, de gestion des risques, de qualité des données, de surveillance humaine et de documentation.

Comment maîtriser une technologie qui évolue plus vite que les réglementations qui l'encadrent ?

Utiliser l'intelligence artificielle pour réguler l'intelligence artificielle n’est pas un paradoxe, mais une nécessité stratégique pour répondre à ce défi de façon efficiente et proactive.

Et si la solution résidait dans l'IA elle-même ?

Nous avons déjà étudié une douzaine de cas où l’IA peut être utile pour satisfaire les exigences de l’AI Act. En voici trois, brièvement décrits :

Exigences : Article 9 –Système de gestion des risques : « … (a) l'identification et l'analyse des risques connus et raisonnablement prévisibles… » ;« … Les systèmes d'IA à haut risque sont testés … à tout moment … » ; « … Les essais sont effectués en fonction de paramètres et de seuils probabilistes préalablement définis et adaptés… ».

Les articles 15 (solutions de résilience notamment) et 17 (procédures de test qualité) sont également concernés.

Solution : Développement de routines de test automatisées et monitoring continu des performances, qui scrutent en permanence leurs propres résultats, détectent les dérives et alertent automatiquement si des seuils préalablement définis sont franchis…

Par exemple, des modèles de scoring crédit génèrent automatiquement des rapports de performance, identifient les baisses de fiabilité et proposent des corrections en temps réel.

Technologies (extrait) : plateformes MLOps & AIPos, Isolation Forest, LSTM

Risques : Multiplication de Faux Positifs si le réglage des seuils n’est pas maîtrisé

Exigences : Bien que le mot éthique n’apparaisse pas dans l’AI Act, il transparait selon nous dans les exigences de transparence et de compréhensibilité, ainsi que les mentions de confiance, de protection de la santé, de la sécurité, des individus et de la société. Voir par exemple les articles 1 (protection, confiance), 13 et 14 (transparence et compréhensibilité), 50 (transparence).

Au-delà, les exigences du RGPD peuvent générer de tels cas d’usage.

Solution : IA explicable (XAI) qui audite ses propres décisions, détecte les biais et propose des ajustements.

Technologies (extrait) : LIME, SHAP pour tous les modèles IA ; DiCE, FACE, … pour les explications contrefactuelles.

Risques : Bien que des recherches importantes sur XAI soient menées, certains modèles, surtout les plus performants, restent opaques.

Exigences : Pour les systèmes à haut risque, assurer une traçabilité complète et une gouvernance des données rigoureuse.

Les Articles 12 (« tenue des journaux »), 11 (« documentation technique »), et 17 (« Système de gestion de la qualité ») concernent la traçabilité, l’article 10 (« Données et gouvernance des données ») détaille les exigences de qualité dans la collecte, l’origine et la gestion des données, ainsi que dans la documentation des processus.

Solution : Génération automatique de journaux détaillés, catalogues de données intelligents, tracking de provenance et certification automatique de qualité.

Technologies (extrait) : Neptune.ai (pour le MLLifecycle management), NLP et IA générative pour la génération automatique de rapports.

Risques : Volumétrie importante des logs, risques de fuite d’information sensible si les flux de données et les stockages sont mal sécurisés.

Au-delà de ces exemples, nous pouvons esquisser une stratégie dans laquelle l’IA est en mesure de résoudre certains des problèmes qu’elle pose. Ou plutôt les IAs, car nous avons constaté dans l’ensemble des cas que la technologie IA qui aide à réguler n’est pas la même que celle qu’elle régule.

Chercher et réaliser des cas d’usage dans le cadre de l’AI Act permet des résultats tangibles et rapides pour une meilleure conformité à l’AI Act.

Cette adéquation entre l’IA à contrôler et l’IA qui contrôle est un bon moyen de rester dynamique dans l’usage d’une technologie qui innove continuellement : le remède évolue à la même vitesse que le symptôme.

Les équipes chargées d’appliquer l’AI Act se familiarisent avec les technologies qu’elles doivent contrôler. Une culture commune aux équipes risque, conformité, innovation, métiers peut ainsi se développer.

C’est également un bon terrain d’entraînement pour développer une conformité aidée par l’IA (osons le terme « AI-aided Compliance »). Les nouveaux règlements et directives DORA, CRR3 CRD6, CSRD, et même RGPD, peuvent eux aussi être en partie traités beaucoup plus efficacement avec l’aide de solutions IA, d’autant plus que de nombreux cas d’usage sont communs à plusieurs exigences.

Cette approche libère un potentiel considérable : automatiser les contrôles et reporting de routine pour que les équipes risque et conformité se concentrent sur l'analyse et la stratégie. À condition bien sûr de garder la main sur les décisions.

L’IA est un atout précieux et fiable pour l’analyse et la synthèse. Pas pour le jugement et la vue d’ensemble.

Nous continuons d’explorer activement les usages possibles de l’IA pour répondre aux exigences de conformité. Pour nous, le futur de la conformité bancaire s'écrit aussi aujourd'hui avec l’aide de l'intelligence artificielle.

Disclaimer : L’écriture de cet article a mobilisé 3 modèles d’IA générative pour approfondir nos recherches et confronter les sources. La rédaction finale est entièrement humaine. #humantouch

Crédits icônes : sulistiana, nangicon, topicons07 from non project